Accueil sur les sources d'énergie

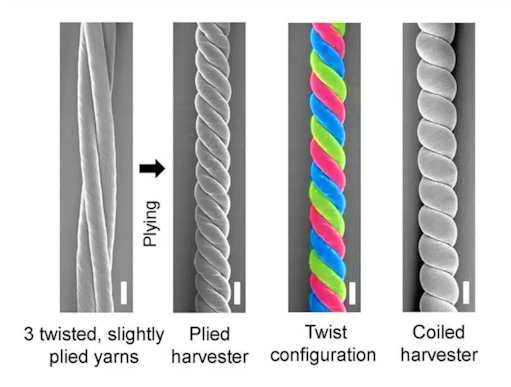

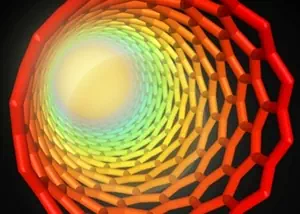

Des chercheurs de l'Université du Texas, à Dallas, ont mis au point de nouveaux fils en nanotubes de carbone capables de convertir le mouvement mécanique en électricité avec un rendement sans précédent ! Ces fils, appelés twistrons, affichent une efficacité de conversion énergétique de 17,4% dans le cas de l'étirement et de 22,4% pour la torsion.

Les twistrons ont été décrits pour la première fois en 2017 par une équipe de chercheurs de l'UT Dallas. C'est l'essor de l'électronique et des appareils portables qui a motivé leur développement : des fils capables de récolter l'énergie de mouvement apparaissaient comme une solution idéale pour disposer d'une alimentation sans batterie, et de faible encombrement. Ils ont donc mis au point des collecteurs d'énergie, fabriqués à partir de fils de nanotubes de carbone dont le diamètre est 10 000 fois inférieur à celui d'un cheveu humain capables de fournir de l'énergie électrique à partir de mouvements de torsion et de traction.

Pour fabriquer ces twistrons, les nanotubes sont filés par torsion pour former des fibres, légères et très résistantes, dans lesquelles des électrolytes peuvent être incorporés. Comme n'importe quelle autre fibre, ils peuvent être incorporés dans les textiles et ainsi, capter les mouvements humains. Ils peuvent même être utilisés dans l'océan pour recueillir l'énergie du mouvement des vagues. Pour générer de l'électricité, les fils doivent être recouverts d'un matériau conducteur ionique, ou d'un électrolyte. Lorsqu'un fil est tordu ou étiré, son volume diminue, ce qui rapproche les charges électriques du fil, cela augmente la tension associée à la charge stockée dans le fil.

Dans leurs précédents travaux, les chercheurs ont réussi à générer une puissance électrique de pointe de 250 watts par kilogramme, en étirant des twistrons 30 fois par seconde. Les twistrons mis au point étaient très élastiques ; pour ce faire, les chercheurs avaient introduit tellement de torsion que les fils s'enroulaient comme un élastique trop torsadé.

Dans une nouvelle étude, la même équipe montre comment elle a réussi à améliorer considérablement l'efficacité de ses twistrons : au lieu d'enrouler une fibre de nanotubes de carbone sur elle-même, les chercheurs ont entrelacé trois brins individuels pour en faire un fil unique d'une manière quasi similaire à celle utilisée pour les fils de laine ou de coton dans l'industrie textile.

Ainsi tressés, entre 2 et 120 Hz, ces nouveaux fils affichent une puissance de pointe gravimétrique et une puissance moyenne plus élevées que tout autre collecteur d'énergie mécanique basé sur des matériaux, rapporte l'équipe.

Les chercheurs ont mené plusieurs expériences pour évaluer les performances de leurs twistrons à trois brins. Ils ont tout d'abord attaché un de leurs twistrons entre un ballon et le fond d'un aquarium rempli d'eau salée, afin de simuler la production d'électricité à partir des vagues de l'océan.

Ils ont également utilisé plusieurs twistrons pour former un réseau de seulement 3,2 milligrammes et les ont étirés à plusieurs reprises pour charger un supercondensateur : celui-ci disposait alors de suffisamment d'énergie pour alimenter cinq petites diodes électroluminescentes, une montre numérique et un capteur numérique d'humidité et de température.

Enfin, l'équipe a également intégré des twistrons dans un patch en coton, qui a ensuite été positionné au niveau du coude d'une personne : des signaux électriques étaient générés dès que celle-ci pliait son coude de manière répétée, suggérant que ces fils de haute technologie pourraient tout à fait être utilisés pour exploiter l'énergie des mouvements humains.

Un générateur bêtavoltaïque est un générateur électrique encore expérimental, en 2011, qui tire son énergie d'une émission radioactive de particules β-, c'est-à-dire des électrons. Un isotope radioactif de l'hydrogène, le tritium, est une des sources principalement étudiée. Contrairement à la plupart des sources nucléaires, qui utilisent une réaction nucléaire pour générer l'énergie qui sera transformée en électricité, les bêtavoltaïques reposent sur un processus de transformation non-thermique.

Les générateurs bêtavoltaïques ont été imaginés au milieu du siècle dernier. En 2005, un nouveau matériau utilisant des diodes à base de silicium poreux a été proposé pour augmenter leur efficacité. Cette augmentation serait principalement due à l'augmentation de la surface du matériau de capture.

Description générale

Ce sont des dispositifs expérimentaux produisant très peu d'énergie à des coûts de revient encore très élevés et qui n'ont actuellement aucune application. Leur force électromotrice provient des électrons produits par les réactions de désintégration β-, la puissance électrique fournie étant directement fonction de l'intensité de la désintégration radioactive et de l'énergie de désintégration à l'oeuvre dans ces composants : cette force électromotrice est structurellement limitée par la taille réduite de ces composants, qui l'empêche de pouvoir devenir significative.

L'idée, popularisée il y a quelques années par certaines revues et sites Web, que ces générateurs soient principalement destinés aux appareils portatifs, tels que les téléphones mobiles, les ordinateurs portables, voire les pacemakers, demeure prématurée et semble pour l'instant fort peu réaliste : ces appareils utilisent aujourd'hui des batteries ayant une autonomie de l'ordre du jour ou de la semaine au maximum, et qui nécessitent donc d'être rechargées très fréquemment, ce qui limite leur portabilité, l'utilisation d'une pile bêtavoltaïque a été présentée par les promoteurs de cette technologie comme permettant de démultiplier la durée d'utilisation sans rechargement, qui pourrait alors, selon eux, atteindre 30 ans dans le cadre d'une utilisation domestique. Plusieurs avantages potentiels sont mis en avant pour justifier les recherches dans cette direction.

- Détail

- La transformation nucléaire n'est pas exothermique, contrairement aux réactions chimiques des piles classiques.

- Une pile bêtavoltaïque en fin de vie ne contient aucun élément nocif, contrairement aux métaux lourds ou non-recyclable contenu dans les piles ordinaires.

- Les particules β- utilisées libèrent une faible quantité d'énergie et sont facilement isolées, par rapport aux rayons γ générés par des appareils plus radioactifs, de sorte que ces générateurs ne devraient pas émettre d'onde ni de particule dangereuse.

Cependant, les générateurs bêtavoltaïques tendent à subir des dégradations internes dues au rayonnement β- qui en diminuent progressivement le rendement, tandis que la source d'énergie elle-même se tarit au fur et à mesure de la désintégration du tritium.

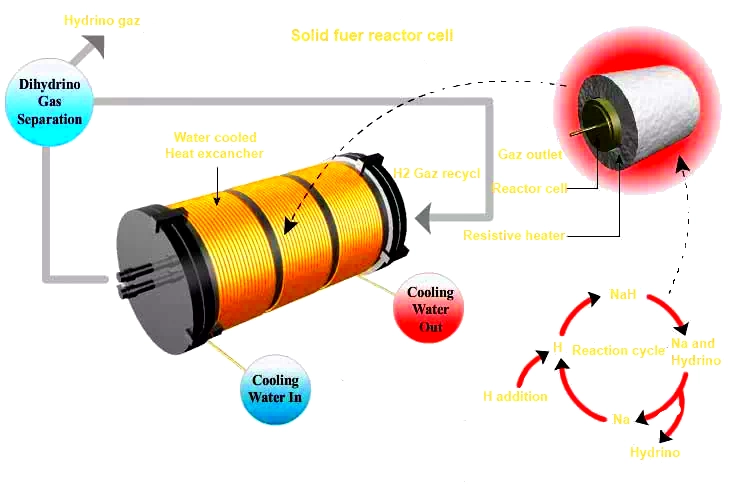

SF-CIHT

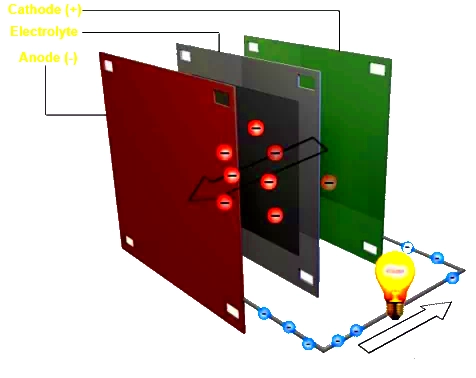

La société BlackLight Power a annoncé mercredi avoir produit plusieurs millions de watts d'électricité dans ses laboratoires grâce à une technologie révolutionnaire, en instance de brevet, appelée "Solid Fuel-Catalyst-Induced-Hydrino-Transition (SF-CIHT)".

L'utilisation d'un carburant solide spécifique, à base d'eau, confiné par les deux électrodes d'une pile SF-CIHT, et auquel est appliquée une intensité de 12.000 ampères, enflamme l'eau en produisant un extraordinaire éclair électrique.

Le carburant est ainsi en mesure d'être continuellement fourni aux électrodes pour continuellement produire de l'électricité.

BlackLight a produit des millions de watts d'électricité dans un volume représentant un dix-millième de litre, ce qui représente une stupéfiante puissance volumique dépassant 10 milliards de watts par litre.

A titre de comparaison, un litre de source d'électricité BlackLight pourrait produire autant d'électricité qu'une centrale électrique dotée d'une puissance supérieure à celle des 4 anciens réacteurs de la centrale nucléaire de Fukushima Daiichi, théâtre d'un des plus grands désastres nucléaires de l'histoire

Sûr et non polluant, le système de production d'électricité convertit par catalyse l'hydrogène présent dans le carburant solide à base d'eau (H2O) en un produit non polluant, une particule d'hydrogène à faible énergie appelée hydrino en permettant aux électrons d'atteindre une orbite plus basse autour du noyau de l'atome.

L'énergie libérée par le carburant à base d'eau (H2O), librement disponible sous forme d'humidité dans l'air, serait 100 fois supérieure à celui d'une quantité équivalente d'essence à indice d'octane élevé.

L'électricité est produite sous forme de plasma, un état physique gazeux ionisé du carburant, en expansion supersonique, essentiellement constitué d'ions positifs et d'électrons libres pouvant être convertis directement en électricité grâce à des convertisseurs magnétohydrodynamiques à rendement élevé.

En utilisant des composants facilement disponibles, BlackLight a conçu un modèle technique de générateur électrique fermé, à l'exception de l'ajout de carburant à base d'eau (H2O), capable de générer 10 millions de watts d'électricité, assez pour alimenter dix mille foyers.

La source d'électricité SF-CIHT serait une innovation révolutionnaire pour toutes les formes de transport automobile, transports routier, ferroviaire et maritime, aviation et aérospatiale, puisque sa puissance volumique est un million de fois supérieure à celle du moteur d'une Formule 1 et dix millions de fois supérieure à celle d'un moteur à réaction.

Les carburants solides et la pile électrochimique CIHT de BlackLight utilisent le même agent catalytique que les nouvelles piles SF-CIHT et ont servi de modèle au docteur Mills lors de l'invention de la pile SF-CIHT productrice de plasma.

Les résultats obtenus par BlackLight, plusieurs fois supérieurs au dégagement maximal théorique d'énergie pour les carburants solides représentatifs, ont été répliqués dans le laboratoire d'applications de Perkin Elmer, sur le site de l'entreprise, avec son instrument commercial. En outre, la pile électrochimique CIHT a également été répliquée de manière indépendante, hors de ces locaux.

Les hydrinos

Les hydrinos sont une forme précédemment inconnue de l'hydrogène, à des états d'énergie inférieurs, produits par le BlackLight Process lors de la libération d'énergie latente contenue dans les atomes d'hydrogène.

L'énergie libérée par la formation d'un hydrino est plus de 200 fois supérieure à celle qui est nécessaire pour extraire l'hydrogène de l'eau par électrolyse. Il apparaît que les piles de la technologie CIHT extraient cette énergie directement en tant qu'électricité. Avec le détournement d'une fraction du pourcentage de puissance électrique, le combustible d'hydrogène peut être créé à partir de l'eau avec la production nette d'énergie sur place. En conséquence, cette énergie peut être produite partout, y compris dans les unités d'habitation, dans les entreprises et dans les automobiles, sans infrastructure de soutien à la génération ou à la distribution de combustible. Les sources d'énergie thermique de BlackLight sont également indépendantes d'une infrastructure de combustible et présentent des avantages supplémentaires par rapport à la production traditionnelle centralisée d'électricité dans les applications d'énergie électrique distribuée autant que dans les opérations de réhabilitation thermique.

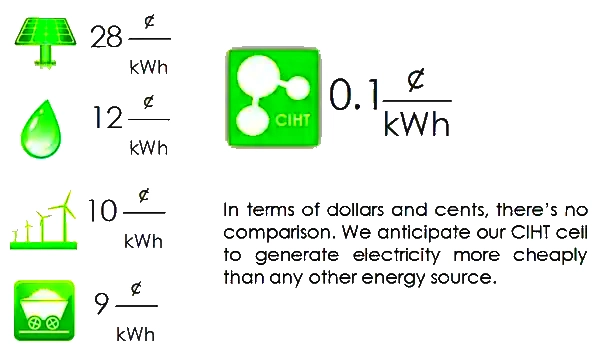

La technologie CIHT a un coût nominal par unité de puissance prévisible par rapport aux systèmes thermiques et elle permet de produire de l'électricité sans nécessiter d'énormes générateurs mécaniques alimentés par une source d'énergie thermique. Aussi, une diffusion plus rapide est-elle possible, en déployant un grand nombre d'unités réparties de manière autonome, qui permettent de contourner les énormes obstacles qui compliquent l'entrée sur les marchés de l'énergie, tels que le développement et la construction de centrales électriques gigantesques de l'ordre du milliard de dollars avec l'infrastructure de distribution de l'énergie qui y est associée.

La source d'énergie peut être transportée et raccordée à votre tableau électrique de façon à alimenter votre maison en suffisance et à produire en outre un surplus d'électricité permettant d'alimenter aussi votre voisinage, a ajouté le Dr Mills. Akridge Energy, un détenteur de licence, compte d'une part déployer des unités de puissance électrique basées sur la technologie CIHT, selon un système de distribution décentralisé, dans des propriétés immobilières commerciales, et d'autre part vendre l'électricité à ses locataires et ultérieurement aux réseaux électriques locaux.

BLP a également annoncé la reproduction d'une émission de lumière à énergie exceptionnellement élevée, inférieure à 80 nanomètres, à partir de l'hydrogène au Harvard Smithsonian Center for Astrophysics. Ces résultats, estimés auparavant impossibles sur la base des théories antérieures, seraient explicables par la formation des hydrinos. L'observation spectrale directe des transitions de l'hydrogène pour former les hydrinos ainsi que leur présence astrophysique généralisée en tant qu'identité de la matière noire de l'univers ont donné lieu à la publication d'un article intitulé Hydrino Continuum Transitions with Cutoffs at 22.8 nm and 10.1 nm (Int. J. Hydrogen Energy) rédigé par le Dr Randell Mills et le Dr Ying Lu.

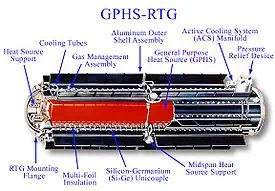

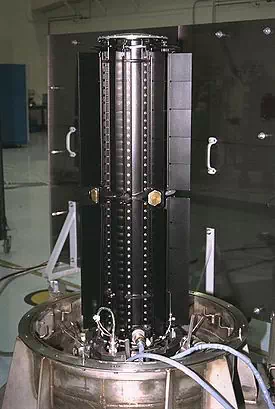

Générateur thermoélectrique à radioisotope

Un générateur thermoélectrique à radioisotope est un générateur électrique nucléaire de conception simple, produisant de l'électricité à partir de la chaleur résultant de la désintégration radioactive de matériaux riches en un ou plusieurs radioisotopes, généralement du plutonium 238 sous forme de dioxyde de plutonium 238PuO2. Aujourd'hui, la chaleur est convertie en électricité par effet Seebeck à travers des couples thermoélectriques : les générateurs produits au siècle dernier utilisaient des matériaux silicium-germanium, ceux produits actuellement mettent en oeuvre plutôt des jonctions PbTe / TAGS, avec une efficacité énergétique n'atteignant jamais 10%. Pour améliorer ces performances, les recherches actuelles s'orientent vers des convertisseurs thermoïoniques et des générateurs Stirling à radioisotope, susceptibles de multiplier le rendement global par quatre.

De tels générateurs sont mis en oeuvre en astronautique pour l'alimentation électrique des sondes spatiales et plus généralement pour alimenter en électricité des équipements requérant une source d'énergie stable et fiable capable de fonctionner de façon continue sur plusieurs années sans maintenance directe — par exemple pour des applications militaires, sous-marines, ou en milieu inaccessible, on avait ainsi conçu des générateurs miniatures pour stimulateurs cardiaques au 238Pu, aujourd'hui remplacés par des technologies plus vertes reposant sur des batteries lithium-ion et de tels générateurs de conception plus simple fonctionnant au strontium 90 ont été utilisés par le passé pour l'éclairage de certains phares isolés sur les côtes de l'URSS.

Source de chaleur

En comparaison d'autres équipements nucléaires, le principe de fonctionnement d'un générateur à radioisotope est simple. Il est composé d'une source de chaleur constituée d'un conteneur blindé rempli de matière radioactive, percé de trous où sont disposés des thermocouples, l'autre extrémité des thermocouples étant reliée à un radiateur. L'énergie thermique traversant les thermocouples est transformée en énergie électrique. Un module thermoélectrique est un dispositif constitué de deux sortes de métaux conducteurs, qui sont connectés en boucle fermée. Si les deux jonctions sont à des températures différentes, un courant électrique est généré dans la boucle.

Le radioisotope retenu doit avoir une demi-vie assez courte, afin de fournir une puissance suffisante. On choisit des demi-vies de l'ordre de quelques dizaines d'années. Il s'agit le plus souvent de plutonium 238, sous forme de dioxyde de plutonium 238PuO2, un puissant émetteur de particules α dont la période radioactive est de 87, 74 ans. Cet isotope est de loin le plus utilisé parce que, outre sa demi-vie particulièrement bien adaptée, il émet tout son rayonnement sous forme de particules α, plus efficacement converties en chaleur que les particules β- et a fortiori que les rayons γ.

Le premier radioisotope utilisé a été le polonium 210 en raison de sa période plus courte de seulement 138, 38 jours et donc de sa très grande puissance de rayonnement, tandis que l'américium 241 offre une alternative moins puissante mais cinq fois plus pérenne en raison de sa période de 432, 2 années :

Décroissance calculée de trois radioisotopes pour GTR

Radioisotope

241Am

238Pu

210Po

Période radioactive

432, 2 ans

87, 74 ans

138, 38 jours

Puissance spécifique

106 W / kg

567 W / kg

140 000 W / kg

Matériau radioactif

241AmO2

PuO2 à 75% de 238Pu

Po à 95% de 210Po

Puissance initiale

97, 0 W / kg

390, 0 W / kg

133 000 W / kg

Après 1 mois

97, 0 W / kg

389, 7 W / kg

114 190 W / kg

Après 2 mois

97, 0 W / kg

389, 5 W / kg

98 050 W / kg

Après 6 mois

96, 9 W / kg

388, 5 W / kg

53 280 W / kg

Après 1 an

96, 8 W / kg

386, 9 W / kg

21 340 W / kg

Après 2 ans

96, 7 W / kg

383, 9 W / kg

3 430 W / kg

Après 5 ans

96, 2 W / kg

374, 9 W / kg

14 W / kg

Après 10 ans

95, 5 W / kg

360, 4 W / kg

0W / kg

Après 20 ans

93, 2W / kg

333, 0W / kg

0W / kg

Après 50 ans

89, 5W / kg

262, 7W / kg

0W / kg

Les isotopes 242Cm et 244Cm ont également été proposés sous forme cm2O3 en raison de leurs propriétés particulières :

Curium 242 donne du plutonium 238 par désintégration α avec une période radioactive de 162, 79 jours, ce qui en fait potentiellement un radioisotope à double détente puisque son produit de désintégration est à son tour utilisable comme source d'énergie pour générateur à radioisotope.

Le curium 244 donne du plutonium 240 par désintégration α avec une période de 18, 10 ans.

Avec une puissance spécifique respectivement de 98 kW / kg pour le 242Cm2O3 et de kW / kg pour le 244Cm2O3, ces céramiques présentent néanmoins l'inconvénient d'émettre un flux important de neutrons en raison d'un taux de fission spontanée respectivement de 6, 2×10-6 et 1, 4×10-6 par désintégration α, ce qui nécessite un blindage plusieurs dizaines de fois plus lourd qu'avec le 238PuO2.

Conversion en électricité

Les éléments thermoélectriques actuellement utilisés pour convertir en électricité le gradient de température généré par la désintégration des radioisotopes sont particulièrement peu efficaces : entre 3 et 7% seulement, n'atteignant jamais 10%. Dans le domaine astronautique, ces thermocouples ont longtemps été réalisés en matériaux silicium-germanium, notamment dans les GPHS-RTG des sondes Ulysses, Galileo, Cassini-Huygens et New Horizons. La nouvelle génération, introduite par le MMRTG pour la mission Mars Science Laboratory, fonctionne avec une jonction dite PbTe/TAGS, c'est-à-dire tellurure de plomb PbTe / tellurures d'antimoine Sb2Te3, de germanium GeTe et d'argent Ag2Te.

Des technologies plus novatrices reposant sur les convertisseurs thermoïoniques permettraient d'atteindre une efficacité énergétique comprise entre 10 et 20%, tandis que des expériences recourant à des cellules thermophotovoltaïques, disposées à l'extérieur du générateur à radioisotope classique équipé d'éléments thermoélectriques, pourraient théoriquement permettre d'atteindre des rendements proches de 30%.

Les générateurs Stirling à radioisotope, utilisant un moteur Stirling pour générer le courant électrique, permettraient d'atteindre une efficacité de 23%, voire davantage en amplifiant le gradient thermique. Le principal inconvénient de ce dispositif est cependant d'avoir des pièces mécaniques en mouvement, ce qui implique de devoir gérer l'usure et les vibrations de ce système.

Utilisation

Un générateur thermoélectrique à radioisotope est particulièrement bien adapté à la production d'une alimentation électrique stable, sur une longue durée et pour maintenir opérationnels pendant plusieurs années les instruments embarqués dans les sondes interplanétaires. Ainsi, le générateur embarqué sur la sonde New Horizons est capable de fournir une alimentation électrique stable de 200 W sur plus de 50 ans. Au bout de deux siècles, la puissance tombe à 100 W. Cependant, en raison du plutonium 238 présent dans un GTR spatial, tout échec au décollage des lanceurs utilisés pour propulser la sonde présente un risque environnemental.

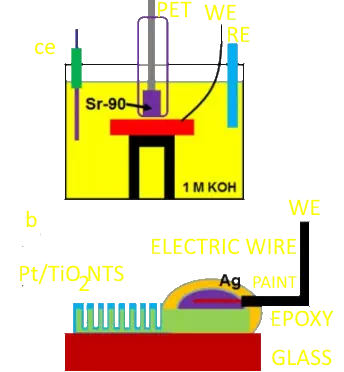

Les générateurs à isotope ont été principalement conçus pour l'exploration spatiale, mais l'Union soviétique les a utilisés pour alimenter des phares isolés à l'aide de générateurs au strontium 90. Ce dernier est sensiblement moins cher que les autres radioisotopes traditionnels, mais émet presque exclusivement des radiations β, à l'origine d'un fort rayonnement X par Bremsstrahlung. Cela ne posait pas de problème majeur compte tenu du fait que ces installations étaient destinées aux endroits isolés et peu accessibles, où elles fournissaient une source d'énergie très fiable, mais présentait tout de même des risques potentiels en cas d'incident ou de dégradation de ces matériels sans surveillance rapprochée. Du millier de générateurs de ce type, utilisant du fluorure de strontium SrF2, voire de titanate de strontium SrTiO3, plus aucun n'est aujourd'hui en état de fonctionner à une puissance acceptable suite à l'épuisement du radioisotope.

Le strontium 90 a une période radioactive de 28, 8 ans (ce qui signifie que la moitié du 90Sr subsiste après 28, 8 ans, le quart après 57, 6 ans etc.), en se désintégrant par désintégration β- pour donner de l'yttrium 90, qui se désintègre à son tour par émission β- avec une demie-vie de 64 heures pour finalement donner du zirconium 90 qui, lui, est stable.

Sécurité

Les générateurs à isotope ne fonctionnent pas comme les centrales nucléaires.

Les centrales nucléaires créent l'énergie à partir d'une réaction en chaîne dans laquelle la fission nucléaire d'un atome libère des neutrons, qui à leur tour entraînent la fission d'autres atomes. Cette réaction, si elle n'est pas contrôlée, peut rapidement croître de façon exponentielle et causer de graves accidents, notamment par la fonte du éacteur.

à l'intérieur d'un générateur à isotope, on utilise seulement le rayonnement naturel du matériau radioactif, c'est-à-dire sans réaction en chaîne, ce qui exclut a priori tout scénario catastrophe. Le carburant est de fait consommé de façon lente, cela produit moins d'énergie mais cette production se fait sur une longue période.

Même si le risque de catastrophe majeure est quasi nul, on n'est cependant pas à l'abri d'une contamination radioactive et chimique car tous les isotopes de plutonium et des autres transuraniens sont aussi chimiquement toxiques : si le lancement d'une sonde spatiale échoue à basse altitude, il y a un risque de contamination localisée, tout comme dans la haute atmosphère, une désintégration de la sonde pourrait engendrer une dissémination de particules radioactives. On dénombre plusieurs accidents de ce type, dont trois, le satellite américain Transit 5BN-3 et 2 sondes russes dont la mission Cosmos 305, ayant conduit à la libération de particules radioactives dans l'atmosphère. Dans les autres cas, aucune contamination n'a pu être détectée et certains générateurs à isotopes ont été récupérés intacts, ayant résisté à la retombée dans l'atmosphère.

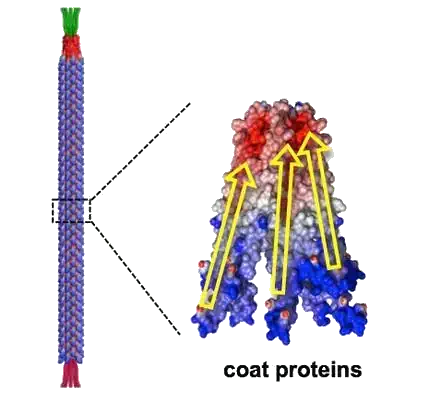

Les scientifiques du Lawrence Berkeley National Laboratory aux Etats-Unis ont développé une méthode pour produire de l'électricité en utilisant des virus inoffensifs capables de convertir l'énergie mécanique en électricité.

Les chercheurs ont développé la technologie par le virus bactériophage M13, un virus qui ne s'attaque qu'aux bactéries et est donc sans danger pour les personnes. Un projet qui pourrait permettre selon les gadgets un avenir proche comme les smartphones qui peuvent être chargés à partir de nos propres mouvements comme la marche.

C'est un générateur qui peut produire la puissance nécessaire pour éclairer un écran à cristaux liquides. Son fonctionnement est produit par la pression de petite électrode, le commutateur serait recouverte par une couche mince de virus conçu, capable de produire une charge électrique.

Il s'agit d'une première étape vers le développement de groupes électrogènes personnelles pour une utilisation dans des nano-dispositifs et autres appareils électroniques basés sur des mécanismes de virus.

Les protéines ont par la suite reçu, grâce à de l'ingénierie génétique, quatre groupements aminés à leur extrémité négative, l'objectif étant d'augmenter la différence de charge entre les deux pôles de chaque chaîne polypeptidique hélicoïdale. Les chercheurs ont poursuivi leurs efforts et sont arrivés à déposer jusqu'à vingt couches de virus les unes sur les autres, dopant ainsi la puissance du générateur. Des électrodes recouvertes d'or et mises au contact des bactériophages se chargent de transférer le courant généré. Une simple pression permet alors de produire de l'électricité.

Les scientifiques testé leur approche en créant un générateur de papier mince qui produit suffisamment de courant pour exploiter une petite affichage à cristaux liquides.

Un film de virus, observé grâce à un microscope, a été soumis à un courant électrique. Les quelque 2.700 protéines de surface recouvrant chaque entité biologique ont alors changé de forme, répondant ainsi aux attentes des chercheurs. En effet, un matériau piézoélectrique se déforme lorsqu'il est traversé par de l'électricité.

Le bactériophage M13 mesure 880 nanomètres de long et présente un diamètre de 6, 6 nanomètres. Il est recouvert de 2.700 protéines chargées. Leur déformation grâce à un procédé mécanique permet de générer du courant. Vu ses dimensions, ce matériel d'origine biologique pourrait être utilisé pour concevoir des nanogénérateurs.

un générateur d'un centimètre carré produit un courant d'une tension de 400 mV, soit le quart d'une pile AAA et d'une intensité de 6 nanoampères.

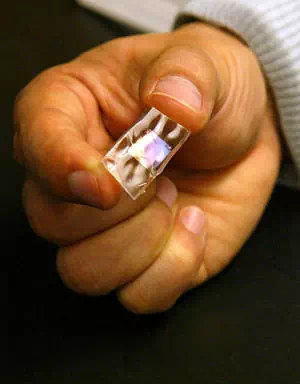

Grâce à la silicone, le corps peut produire de l'électricité

Marcher pour recharger son portable et respirer pour alimenter son pacemaker. Souple et piézo-électrique, l'invention convertit l'énergie mécanique, donc le mouvement, en électricité.

Les chercheurs de l'Université de Princeton ont réussi à créer une lamelle alliant la flexibilité d'un silicone et le puissant effet piézo-électrique du titano-zirconate de plomb, ou plus simplement PZT.

Ce PZT est une céramique qui convertit 80% de l'énergie mécanique qu'elle reçoit lorsqu'elle est déformée en énergie électrique, un rendement exceptionnel pour un matériau piézo-électrique. Comme le corps dégage peu d'énergie lors des ses mouvements, il est important que ce taux de conversion soit élevé. Le PZT est 100 fois plus efficace que le quartz, un autre matériau piézo-électrique souligne Michael McAlpine, ingénieur en mécanique de Princeton.

Le silicone a également l'avantage d'être souple.

Après production à haute température de céramiques PZT, ils en ont extrait chimiquement par microgravure des nanorubans. Ils les ont ensuite incorporés dans des feuilles de silicone.

Autres avantages de leur création, elle est biocompatible et adaptable en dimensions tout en étant productible à l'aide des techniques d'impression microélectronique.

Sa biocompatibilité, c'est-à-dire son absence d'effet nocif pour l'organisme et l'absence de réaction de rejet, permettrait par exemple d'implanter ce générateur près des poumons pour alimenter un pacemaker. Le simple mouvement de la cage thoracique lors de la respiration pourrait alors suffire à générer le courant électrique nécessaire.

Selon ses concepteurs, l'excellente performance de l'assemblage de piézo-rubans couplée avec la souplesse et la biocompatibilité de ce silicone pourrait ouvrir un boulevard dans la recherche fondamentale et appliquée .

Avec la multiplication des textiles intelligents, des cellules solaires et des batteries imprimables, ce type de matériau pourrait en effet promettre des associations intéressantes.

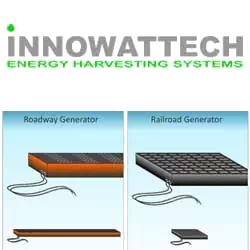

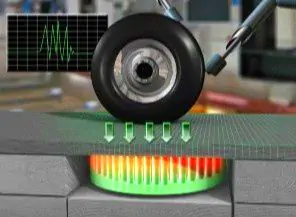

Innowattech, une start-up israélienne va tester prochainement sa technologie piézo-électrique sur 100 mètres de bitume.

La technologie du nom d'IPEG pour Piezo Electric Generator va se servir de milliers de cristaux piézo-électriques intégrés à la route afin de récupérer une certaine quantité d'énergie. Non seulement, ces cristaux sont en mesure d'exploiter l'énergie mécanique issue du poids et du mouvement du véhicule, mais ils peuvent aussi récupérer l'énergie des vibrations et des changements de température.

Selon un savant calcul, 500 camions passant sur un kilomètre de route, à une vitesse moyenne de 72 kilomètres à l'heure peuvent produire 200 kWh par heure. C'est assez d'électricité pour assurer la consommation moyenne de 300 familles

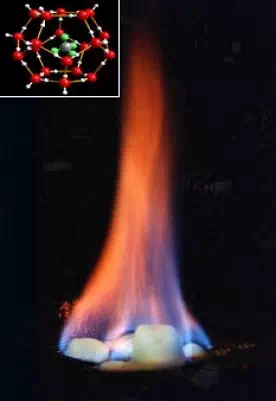

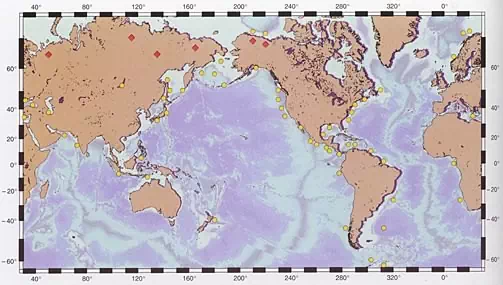

On estime aujourd'hui que les hydrates de méthane des fonds océaniques contiennent deux fois plus en équivalent carbone que la totalité des gisements de gaz naturel, de pétrole et de charbon connus mondialememt. Le long de la seule côte sud-est des USA, une zone de 26 000 kilomètres carrés contient 35 Gt (gigatonnes = milliards de tonnes) de carbone, soit 105 fois la consommation de gaz naturel des USA en 1996! La carte qui suit, extraite de Sues, Bohrmann, Greinert et Lausch, montre la répartition des gisements connus d'hydrates de méthane dans le monde.

Les points jaunes indiquent les gisements sur les plateaux ou les talus continentaux, les losanges rouges, les gisements dans le pergélisol (sol gelé en permanence).

Sous des conditions de température et de pression particulières, la glace (H2O) peut piéger des molécules de gaz, formant une sorte de cage emprisonnant les molécules de gaz. On appelle les composés résultants des hydrates de gaz ou encore des clathrates. Les gaz piégés sont variés, dont le dioxyde de carbone (CO2), le sulfure d'hydrogène (H2S) et le méthane (CH4).

Ces cages cristallines peuvent stocker de très grandes quantité de gaz. Le cas qui nous intéresse ici est celui de l'hydrate de méthane, une glace qui contient une quantité énorme de gaz: la fonte de 1 centimètre cube de cette glace libère jusqu'à 164 centimètre cubes de méthane!

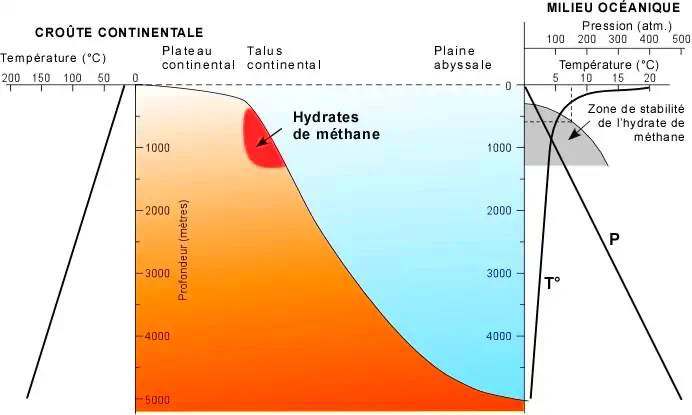

Origine et stabilité des hydrates de méthane

Une importante quantité de matière organique qui se dépose sur les fonds océaniques est incorporée dans les sédiments. Sous l'action des bactéries anaérobies, ces matières organiques se transforment en méthane dans les premières centaines de mètres de la pile sédimentaire.

Un volume très important de méthane est ainsi produit. Une partie de ce méthane se combine au molécules d'eau pour former l'hydrate de méthane, dans une fourchette bien définie de température et de pression. Vous trouverez des diagrammes plus complets aux liens internet conseillés à la fin de cette page.

Dans la zone en gris, eau et méthane se combinent pour former un hydrate à l'état de glace, alors qu'à l'extérieur de cette zone, les deux composés sont séparés et se trouvent sous leur propre état, liquide et gaz. C'est dire que l'hydrate de méthane est stable sous les conditions de température et de pression exprimées par la zone en gris et instable sous les conditions à l'extérieur de cette zone. Par exemple, un hydrate de méthane qui se trouve dans les sédiments océaniques par 600 mètres de fond à 7°C est stable; il deviendra instable avec une augmentation de température de moins de 1°C. Devenir instable signifie que la glace fond et libère son gaz méthane à raison de 164 centimètres cubes de gaz par centimètre de glace.

On retrouve les hydrates de méthane en milieu océanique, principalement à la marge des plateaux et sur les talus continentaux, mais aussi à plus faible profondeur dans les régions très froides, comme dans l'Arctique.

La marge des plateaux continentaux et les talus constituent une zone privilégiée pour accumuler les hydrates de méthane parce que c'est là que se dépose la plus grande quantité de matières organiques océaniques.

On retrouve aussi des hydrates de méthane dans les pergelisols, c'est-à-dire dans cette couche du sol gelée en permanence, même durant les périodes de dégel en surface. Le grand volume de matières organiques terrestres accumulées dans les sols est transformé en méthane biogénique qui, au contact de l'eau est piégé dans des hydrates. Les pressions y sont faibles, mais la température très froide, bien au-dessous de 0°C.

à mesure que les réserves conventionnelles d'hydrocarbure s'épuisent, on devra se rabattre sur les réserves dites non-conventionnelles, comme les gisements des régions éloignées et d'exploitation onéreuse, les sables bitumineux et peut-être un jour, les hydrates de méthane. Comme mentionné plus haut, les hydrates de méthane des fonds océaniques constituent une réserve énergétique énorme, mais pour l'instant inaccessible. Cette glace méthanique se trouve, soit dans les interstices du sédiment entre les particules de sable ou d'argile cimentant ces derniers ou sous forme de vésicules dans les sédiments, soit en couches de plusieurs millimètres ou centimètres d'épaisseur parallèles aux strates ou en veines les recoupant.

Les hydrates de méthane sont donc dispersés dans les sédiments et ne peuvent être exploités par des forages conventionnels; il faudrait plutôt penser à une exploitation massive du sédiment à l'aide de dragues comme on le fait par exemple pour nettoyer les chenaux de navigation des sables et des boues, ou encore d'un système sophistiqué de pompage du sédiment. Mais voilà un énorme risque de déstabiliser rapidement les hydrates et de libérer des quantités considérables de méthane dans l'atmosphère, sans compter les accidents probables associés à ce genre d'exploitation. Il n'en demeure pas moins que l'industrie pétrolière salive à la pensée d'avoir peut-être un jour accès à de telles réserves.

Une déstabilisation massive des hydrates de méthane causée par exemple par une augmentation de 1 ou 2°C de la température des océans, ce qui est tout à fait compatible avec les modèles climatiques actuels, risque de produire une augmentation catastrophique des gaz atmosphériques à effet de serre. Une telle déstabilisation pourrait aussi causer d'immenses glissements de terrain sous-marins sur le talus continental, entraînant des tsunamis très importants qui affecteraient les populations riveraines. Ce pourrait être là deux des effets catastrophiques du réchauffement climatique actuel causé par une augmentation des gaz atmosphériques à effet de serre. Le méthane eat 21 fois plus efficace que le CO2 comme gaz à effet de serre !

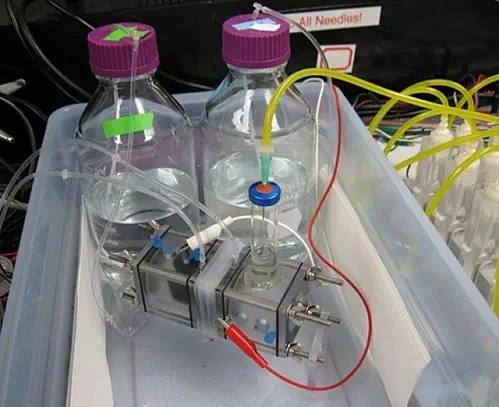

Energie inépuisable : eau salée, de l'eau douce, de la matière organique et des bactéries bien choisies : et voilà un dispositif capable de produire de l'hydrogène gazeux. Pour l'instant expérimental et coûteux, le procédé pourrait être amélioré

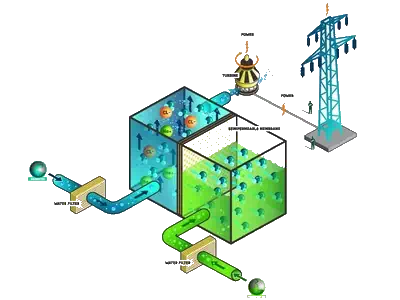

Ce système peut produire de l'hydrogène partout où il y a de l'eau sale à proximité d'eau de mer : c'est ainsi que Bruce Logan, de l'université de Pennsylvanie résume les possibilités de ses MREC, traduisible par cellule d'électrolyse par électrodialyse inverse microbienne. L'idée est de réaliser une hydrolyse pour produire de l'hydrogène gazeux, lequel est un bon vecteur d'énergie, en utilisant une double source d'électricité produite gratuitement : l'électrodialyse inverse et des bactéries.

Il existe effectivement des bactéries qui rejettent des électrons quand elles mangent. Bruce Logan s'intéresse à l'utilisation des eaux usées depuis 2004 et avait décrit en 2005 une version biologique de la pile à combustible, dans laquelle de la matière organique est dégradée dans un compartiment peuplé de bactéries et capable de produire, un peu, d'électricité.Mais la production d'une MFC est trop faible pour une hydrolyse. L'idée existe de produire de l'hydrogène par ce moyen, mais il faut une source d'électricité complémentaire, donc externe. Les travaux précédents montrent que de tels systèmes peuvent générer 0, 3 volt par cellule alors qu'il en faut 0, 414 pour une hydrolyse.

Quant à l'électrodialyse, c'est un procédé connu pour extraire les ions d'un liquide à l'aide d'un courant électrique. Avec un jeu de membranes ne laissant passer que les ions positifs pour les unes et les négatifs pour les autres. Peu efficace, la méthode n'est guère prisée. La réaction inverse est possible : avec deux sources d'eau de salinités différentes traversant des membranes alternativement positives et négatives, on peut produire de l'électricité. De l'eau douce et de l'eau de mer peuvent ainsi devenir un générateur d'électricité. Mais là encore, le résultat est médiocre et insuffisant pour une hydrolyse. Il faudrait 25 paires de membranes pour obtenir la tension de 1, 8 volt nécessaire pour y parvenir, expliquent les chercheurs, ce qui ruinerait la rentabilité de l'appareil à cause de la puissance consommée par le pompage de l'eau.

L'idée du professeur Logan a été d'additionner ces deux méthodes. Des bactéries nourries de matières organiques, produisent du courant électrique, lequel est complété par celui issu de l'électrodialyse inverse. Il suffit d'ajouter de l'eau douce, de l'eau salée et quelques membranes

Dans la description du dispositif exposé dans la revue Pnas, l'équipe annonce des résultats modestes mais réels. Leur appareil produit 0, 8 à 1, 6 mètre cube d'hydrogène gazeux par jour pour 1 mètre cube d'eau utilisé. Le rendement est compris entre 58 et 64% avec les systèmes testés. Ils utilisent des électrodes en platine, ce qui grève considérablement le coût du procédé. Mais les chercheurs américains sont persuadés qu'un matériau moins onéreux pourrait convenir. Ils citent le sulfure de molybdène, qui ne descendrait le rendement que jusqu'à 50%.

Le procédé, de plus, reste complexe et est loin d'être au point. Mais il semble astucieux et même prometteur. Produire localement de l'hydrogène à partir d'eaux usées ou de déchets organiques pour charger des piles à combustibles pourrait à terme d'une phse de recherche et développement devenir prometteuse

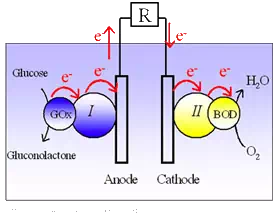

Des chercheurs du CNRS sont parvenus à mettre au point une biopile fonctionnant à partir de la photosynthèse des plantes. Ce dispositif, qui convertit l'énergie solaire et chimique en énergie électrique, pourrait avoir des applications médicales.

Les chercheurs du Centre de recherche Paul Pascal du CNRS, à Bordeaux, ont mis au point une biopile qui fonctionne à partir du glucose et du dioxygène (O2), deux produits issus du processus de la photosynthèse par lequel les plantes convertissent l'énergie solaire en énergie chimique. Durant ce processus, en présence de lumière visible, le dioxyde de carbone (CO2) et l'eau (H20) sont transformés en glucose et en dioxygène (O2) dans une série complexe de réactions chimiques.

Cette biopile est composée de deux électrodes modifiées avec des enzymes : la glucose oxydase (GOx) à l'anode et l'enzyme bilirubine oxydase (BOD) à la cathode. Techniquement, à l'anode, les électrons sont transférés du glucose vers la glucose oxydase (GOx), de la GOx vers le polymère I puis du polymère I, vers l'électrode. à la cathode, les électrons sont transférés vers le polymère II, puis du polymère II vers la bilirubine oxydase (BOD) et enfin de BOD vers l'O2.

Convertir l'énergie solaire en énergie électrique Après avoir, implanté cette pile dans un cactus, les chercheurs du CNRS ont pu suivre l'évolution de la photosynthèse in vivo en temps réel. Ils ont pu observer l'augmentation du courant électrique lorsque qu'une lampe est allumée et une diminution lorsque celle-ci est éteinte. Les chercheurs ont ainsi montré qu'une biopile implantée dans un cactus pouvait générer une puissance de 9µW (microwatt) par cm2.Le rendement étant proportionnel à l'intensité de l'éclairage, une illumination plus intense accélère la production de glucose et d'O2 (photosynthèse), il y a donc plus de combustible pour faire fonctionner la biopile, explique le CNRS.

Un dispositif à vocation médicale si à très long terme, un tel dispositif pourrait contribuer à produire de l'énergie électrique ''d'une façon écologique et renouvelable, l'objectif de ces travaux est avant tout médical. Dans ce cas, la biopile fonctionnerait alors sous la peau de façon autonome (in vivo) en puisant l'énergie chimique du couple oxygène-glucose naturellement présent dans les fluides physiologiques, explique le CNRS. Elle pourrait ainsi alimenter des dispositifs médicaux implantés, tels que, par exemple, des capteurs autonomes sous-cutanés mesurant le taux de glucose chez les patients diabétiques.

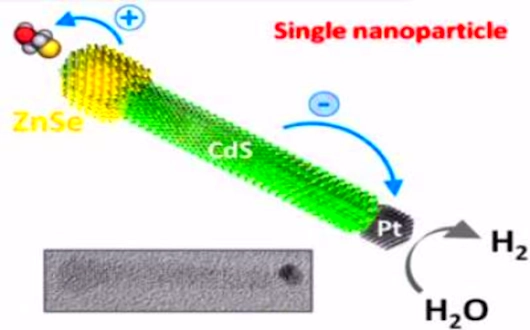

Les panneaux solaires peuvent désormais produire de l'électricité la nuit, sans lumière du soleil. C'est une nouvelle technologie de panneau solaire qui produit de l'hydrogène gazeux en même temps que l'électricité pendant la journée et la nuit cet hydrogène alimente les piles à combustible.

Le Dr Mikhail Zamkov de l'université de Bowling Green à l'Ohio et son équipe ont utilisé deux nanocristaux synthétiques inorganiques pour la fabrication des panneaux solaires plus durables et capables de produire de l'hydrogène gazeux. La tige en nanocristal produit de l'hydrogène par photo catalyse. Les nanocristaux synthétiques produisent quant à eux de l'électricité à partir de la lumière du soleil et comme ils sont inorganiques, ils sont plus faciles à recharger et moins sensibles à la chaleur que leurs homologues organiques.

Le premier nanocristal est en forme de tige, ce qui permet la séparation de charge nécessaire pour produire de l'hydrogène gazeux, une réaction connue sous le nom de photo catalyse. Le deuxième nanocristal est composé de couches empilées et génère de l'électricité car il est photovoltaïque. Le principal avantage de cette technique est qu'elle permet de coupler l'absorption de lumière et la photo catalyse.

Les deux nouveaux types de nanocristaux ont la capacité de remplacer les molécules organiques traditionnelles dans la construction des panneaux solaires. A l'heure actuelle, la nouvelle technologie solaire est à l'étape de la recherche. Les chercheurs pensent que cette nouvelle technologie pourra être produite en masse. Ils pensent aussi que la technologie pourrait être une excellente alternative aux actuelles méthodes de collecte de l'énergie solaire.

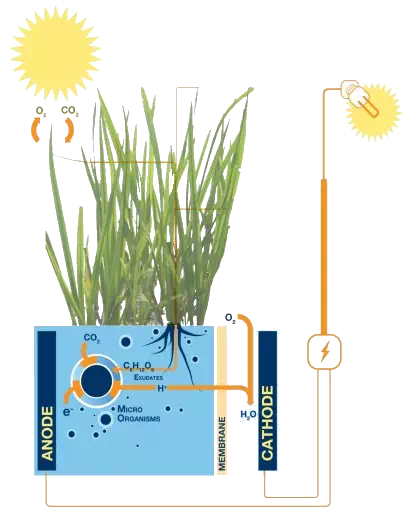

D'après les statistiques, les zones humides recouvrent environ 6% de la surface terrestre. Une nouvelle technologie de piles à combustible microbiennes pour plantes développée à l'Université de recherche de Wageningen aux Pays-Bas pourrait transformer ces zones en une source viable d'énergie renouvelable. Plus que cela, les développeurs estiment que leur technologie pourrait être utilisée pour fournir de l'électricité aux communautés éloignées et utiliser les toits verts pour fournir de l'électricité aux ménages.

Les piles à combustible microbiennes produisent de l'électricité pendant que les plantes continuent de croître.

Il fonctionne en utilisant les 70% de la matière organique produite par photosynthèse, non utilisée par la plante et qui est excrétée par les racines. Comme des bactéries d'origine naturelles se trouvent autour des racines pour absorber ces résidus organiques, des électrons sont libérés en tant que déchet. En plaçant une électrode à proximité de la bactérie pour absorber ces électrons, l'équipe de recherche de Wageningen UR, dirigé par Marjolein Helder, a réussi à produire de l'électricité.

Bien que les piles à combustible microbiennes ne génèrent actuellement que 0, 4 W / m² de la croissance des plantes, les chercheurs disent aussi que les futurs systèmes pourrait générer jusqu'à 3, 2 W / m², ce qui permettrait à un toit de 100 m² d'alimenter en électricité une maison avec une consommation moyenne de 2.800 kWh par an.

Les chercheurs pensent que ces toits producteurs d'énergie verte pourraient devenir une réalité dans les prochaines années, avec une production d'électricité à grande échelle dans les marais autour du monde à partir de 2015. La technologie fonctionne avec divers types de plantes y compris les graminées.

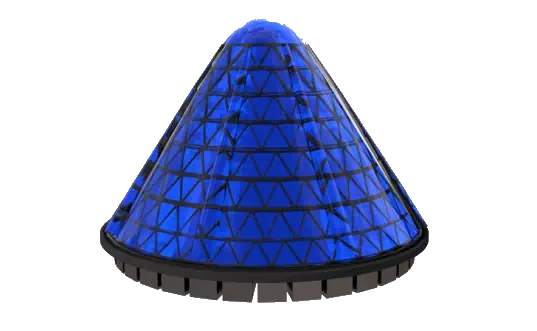

La cellule Spin V3 est le premier d'une série de technologies solaires basés sur notre technologie en instance de brevet. Environ un mètre de haut et un mètre de large et de produisant 1Kw d'électricité, la sentinelle peut être utilisé dans une variété de configurations pour répondre à des déploiements de batteries solaires, supports de toit ou des installations industrielles à domicile.

Pour les zones qui nécessitent une plus grande densité de puissance, le pôle de puissance est la réponse. Il s'agit d'un pôle qui contient 10 cellules Spin ou 10KWp, dans un encombrement de 13 m². Les cellules de spin sont placés avec une précision mathématique pour s'assurer qu'il n'y ait ombrage minimal. Non seulement cela crée une densité de puissance de manière significative grande, mais supprime également la préoccupation des inondations, tout en atténuant l'impact sur l'environnement.

La lumière est transférée à l'électricité en nanosecondes. La chaleur est transférée en millisecondes (1.000.000 X plus). La PV sur le cône intérieur de la cellule de filage capte la lumière, génère l'énergie électrique et tourne alors loin avant que la chaleur puisse être transférée au PV.

La conception de brevet en instance V3solar offre également un haut niveau d'efficacité de PV. Tests à ce jour ont montré des améliorations dans les conditions de laboratoire d'environ 20%, ce qui soulève effectivement l'efficacité du PV de 20% à 24%.

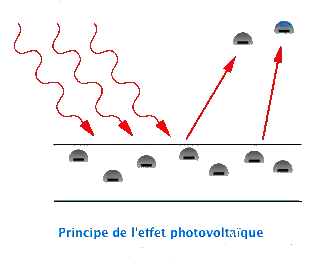

Une cellule photovoltaïque est un composant électronique qui, exposé à la lumière (photons), produit de l'électricité. C'est l'effet photovoltaïque qui est à l'origine du phénomène. La tension obtenue est fonction de la lumière incidente. La cellule photovoltaïque délivre une tension continue.

Les cellules photovoltaïques les plus répandues sont constituées de semi-conducteurs, principalement à base de silicium (Si) et plus rarement d'autre semi-conducteurs : séléniure de cuivre et d'indium (CuIn(Se)2 ou CuInGa(Se)2), tellurure de cadmium (CdTe) etc. Elles se présentent généralement sous la forme de fines plaques d'une dizaine de centimètres de côté, prises en sandwich entre deux contacts métalliques, pour une épaisseur de l'ordre du millimètre.

Les cellules sont souvent réunies dans des modules solaires photovoltaïques ou panneaux solaires, en fonction de la puissance recherchée.

Histoire

Le principe de l'effet photoélectrique (transformation directe d'énergie portée par la lumière en électricité) a été appliqué dès 1839 par Antoine Becquerel qui a noté qu'une chaîne d'éléments conducteurs d'électricité donnait naissance à un courant électrique spontané quand elle était éclairée. Plus tard, le sélénium puis le silicium (qui a finalement pour des raisons de coût supplanté le cadmium-tellure ou le cadmium-indium-sélénium également testés) se sont montrés aptes à la production des premières cellules photovoltaïques (posemètres pour la photographie dès 1914, puis 40 ans plus tard (en 1954) pour une production électrique. La recherche porte également aujourd'hui sur des polymères et matériaux organiques susceptibles (éventuellement souples) qui pourraient remplacer le silicium.

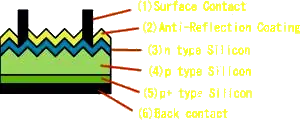

Principe de fonctionnement

Dans un semi-conducteur exposé à la lumière, un photon d'énergie suffisante arrache un électron, créant au passage un trou. Normalement, l'électron trouve rapidement un trou pour se replacer et l'énergie apportée par le photon est ainsi dissipée. Le principe d'une cellule photovoltaïque est de forcer les électrons et les trous à se diriger chacun vers une face opposée du matériau au lieu de se recombiner simplement en son sein : ainsi, il apparaîtra une différence de potentiel et donc une tension entre les deux faces, comme dans une pile.

Pour cela, on s'arrange pour créer un champ électrique permanent au moyen d'une jonction PN, entre deux couches dopées respectivement P et N :

- Détail

- La couche supérieure de la cellule est composée de silicium dopé N. Dans cette couche, il existe une quantité d'électrons libres supérieure à une couche de silicium pur, d'où l'appellation de dopage N, comme négatif (charge de l'électron). Le matériau reste électriquement neutre : c'est le réseau cristallin qui supporte globalement une charge positive.

- La couche inférieure de la cellule est composée de silicium dopé P. Cette couche possèdera donc en moyenne une quantité d'électrons libres inférieure à une couche de silicium pur, les électrons sont liés au réseau cristallin qui, en conséquence, est chargé positivement. La conduction électrique est assurée par des trous, positifs (P).

Au moment de la création de la jonction P-N, les électrons libres de la région N rentrent dans la couche P et vont se recombiner avec les trous de la région P. Il existera ainsi, pendant toute la vie de la jonction, une charge positive de la région N au bord de la jonction (parce que les électrons en sont partis) et une charge négative dans la région P au bord de la jonction (parce que les trous en ont disparu), l'ensemble forme la Zone de charge d'espace (ZCE) et il existe un champ électrique entre les deux, de N vers P. Ce champ électrique fait de la ZCE une diode, qui ne permet le passage du courant que dans un sens : les électrons peuvent passer de la région P vers la région N, mais pas en sens inverse, inversement les trous ne passent que de N vers P.

En fonctionnement, quand un photon arrache un électron à la matrice, créant un électron libre et un trou, sous l'effet de ce champ électrique ils partent chacun à l'opposé : les électrons s'accumulent dans la région N (qui devient le pôle négatif ), tandis que les trous s'accumulent dans la couche dopée P (qui devient le pôle positif ). Ce phénomène est plus efficace dans la ZCE, où il n'y a pratiquement plus de porteurs de charges (électrons ou trous) puisqu'ils se sont annihilés, ou à proximité immédiate de la ZCE : lorsqu'un photon y crée une paire électron-trou, ils se séparent et ont peu de chance de rencontrer leur opposé, alors que si la création a lieu plus loin de la jonction, l'électron (resp. le trou) nouveau conserve une grande chance de se recombiner avant d'atteindre la zone N (resp. la zone P). Mais la ZCE est forcément très mince, aussi n'est-il pas utile de donner une grande épaisseur à la cellule.

En somme, une cellule photovoltaïque est l'équivalent d'un générateur de courant auquel on a adjoint une diode.

Il faut ajouter des contacts électriques (qui laissent passer la lumière en face éclairée : en pratique, on utilise un contact par une grille), une couche antireflet pour assurer une bonne absorption des photons etc.

Pour que la cellule fonctionne et produise le maximum de courant, on ajuste le gap du semi-conducteur au niveau d'énergie des photons. On peut éventuellement empiler les jonctions, de façon à exploiter au mieux le spectre d'énergie des photons, ce qui donne les cellules multi-jonctions.

Technique de fabrication

Le silicium est actuellement le matériau le plus utilisé pour fabriquer les cellules photovoltaïques. On l'obtient par réduction à partir de silice, composé le plus abondant dans la croûte terrestre et notamment dans le sable ou le quartz. La première étape est la production de silicium dit métallurgique, pur à 98% seulement, obtenu à partir de morceaux de quartz provenant de galets ou d'un gisement filonien (la technique de production industrielle ne permet pas de partir du sable). Le silicium de qualité photovoltaïque doit être purifié jusqu'à plus de 99, 999%, ce qui s'obtient en transformant le silicium en un composé chimique qui sera distillé puis retransformé en silicium. Le silicium est produit sous forme de barres nommées lingots de section ronde ou carrée. Ces lingots sont ensuite sciés en fines plaques mises au carré (si nécessaire) de 200 micromètres d'épaisseur qui sont appelées wafers. Après un traitement pour enrichir en éléments dopants (P, As, Sb ou B) et ainsi obtenir du silicium semi-conducteur de type P ou N, les wafers sont métallisés : des rubans de métal sont incrustés en surface et reliés à des contacts électriques. Une fois métallisés les wafers sont devenus des cellules photovoltaïques.

La production des cellules photovoltaïques nécessite de l'énergie et on estime qu'un module photovoltaïque doit fonctionner environ deux à trois ans suivant sa technique de fabrication pour produire l'énergie qui a été nécessaire à sa fabrication (retour énergétique du module).

Les techniques de fabrication et les caractéristiques des principaux types de cellules sont décrits dans les trois paragraphes suivants. Il existe d'autres types de cellules actuellement à l'étude, mais leur utilisation est pratiquement négligeable.

Les matériaux et procédés de fabrication font l'objet de programmes de recherches ambitieux pour réduire les coûts de possession et de recyclage des cellules photovoltaïques. Les techniques couches minces sur substrats banalisés semblent recueillir les suffrages de l'industrie naissante. En 2006 et 2007, la croissance de la production mondiale de panneaux solaires a été freinée par manque de silicium et les prix des cellules n'ont pas baissé autant qu'espéré. L'industrie cherche à faire baisser la quantité de silicium utilisé. Les cellules monocristallines sont passées de 300 microns d'épaisseur à 200 et on pense maintenant atteindre rapidement les 180 puis 150 microns, diminuant la quantité de silicium et d'énergie nécessaire, mais aussi les prix.

Cellule en silicium amorphe

Le silicium lors de sa transformation, produit un gaz, qui est projeté sur une feuille de verre. La cellule est gris très foncé. C'est la cellule des calculatrices et des montres dites solaires.

- Détail

- Avantages :

- fonctionne avec un éclairement faible ou diffus (même par temps couvert, y compris sous éclairage artificiel de 20 à 3000 lux)

- un peu moins chère que les autres techniques

- intégration sur supports souples ou rigides.

- Inconvénients :

- rendement faible en plein soleil, de 5% à 7%

- nécessité de couvrir des surfaces plus importantes que lors de l'utilisation de silicium cristallin (ratio Wc / m² plus faible, environ 60 Wc / m²)

- performances qui diminuent avec le temps dans les premiers temps d'exposition à la lumière naturelle (3-6 mois), pour se stabiliser ensuite (-10 à 20% selon la structure de la jonction).

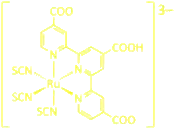

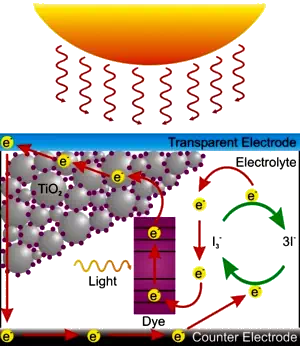

Egalement appelées cellules à pigment photosensible, les cellules Grätzel ont été nommées ainsi en référence à leur concepteur, Michael Grätzel, de l'Ecole polytechnique fédérale de Lausanne.

Il s'agit d'un système photoélectrochimique inspiré de la photosynthèse végétale constitué d'un électrolyte donneur d'électron sous l'effet d'un pigment excité par le rayonnement solaire. La force électromotrice de ce système vient de la rapidité avec laquelle l'électrolyte compense l'électron perdu par le pigment excité avant que ce dernier ne se recombine : le pigment photosensible est imprégné dans un matériau semiconducteur fixé à la paroi transparente et conductrice située face au soleil, de sorte que l'électron libéré par le pigment diffuse jusqu'à la paroi conductrice à travers le matériau semiconducteur pour venir s'accumuler dans la paroi supérieure de la cellule et générer une différence de potentiel avec la paroi inférieure.

Fonctionnement d'une cellule Grätzel.

Ces dispositifs sont prometteurs car ils font intervenir des matériaux bon marché mis en oeuvre avec des technologies relativement simples. La première cellule à pigment photosensible démontrée à l'EPFL en 1991 par M. Grätzel et B. O'Regan utilisait :

- Détail

- Une paroi supérieure en oxyde d'étain dopé au fluor SnO2•F, qui est un matériau à la fois transparent et conducteur d'électricité

- Sur la face intérieure de cette paroi, de l'oxyde de titane TiO2 pulvérulent semiconducteur dont la surface était imprégnée de polypyridine au ruthénium comme pigment photosensible

- Un électrolyte iodure / triiodure (I–/I3–) baignant l'ensemble en assurant la conduction avec la paroi inférieure de la cellule, qui fermait le circuit.

- Elles pourraient être améliorées par des technologies Plasmoniques

Ces cellules ont atteint en laboratoire des rendements de 11% mais sont produites commercialement avec des rendements de 3 à 5%, pour un coût d'environ 2 400 € / kWc.

Lors du refroidissement, le silicium fondu se solidifie en ne formant qu'un seul cristal de grande dimension. On découpe ensuite le cristal en fines tranches qui donneront les cellules. Ces cellules sont en général d'un bleu uniforme.

- Détail

- Avantages :

- bon rendement, de 14% à 16%

- bon ratio Wc / m2 (˜150 Wc / m²)ce qui permet un gain de place si nécessaire

- nombre de fabricants élevé.

- Inconvénients :

- coût élevé.

Une cellule photovoltaïque à base de silicium multicristallin

Pendant le refroidissement du silicium dans une lingotière, il se forme plusieurs cristaux. La cellule photovoltaïque est d'aspect bleuté, mais pas uniforme, on distingue des motifs créés par les différents cristaux.

- Détail

- Avantages :

- cellule carrée (à coins arrondis dans le cas du Si monocristallin) permettant un meilleur foisonnement dans un module

- bon rendement de conversion, environ 100 Wc / m², mais cependant un peu moins bon que pour le monocristallin

- lingot moins cher à produire que le monocristallin.

- Inconvénient :

- rendement faible sous un faible éclairement.

Polycristallin ou multicristallin, On parlera ici de silicium multicristallin .Le terme polycristallin est utilisé pour les couches déposées sur un substrat (petits grains).

Cellule Tandem

Empilement monolithique de deux cellules simples. En combinant deux cellules (couche mince de silicium amorphe sur silicium cristallin par exemple) absorbant dans des domaines spectraux se chevauchant, on améliore le rendement théorique par rapport à des cellules simples distinctes, qu'elles soient amorphes, cristallines ou microcristallines.

- Détail

- Avantage :

- sensibilité élevée sur une large plage de longueur d'onde. Excellent rendement.

- Inconvénient :

- coût élevé dû à la superposition de deux cellules.

Il ne suffisait pas d'y penser. Au fil de la journée ou des mouvements de son support, une surface courbe récupère mieux l'énergie solaire qu'un plan. Encore faut-il trouver un moyen de créer des structures de petites tailles aux formes idéales.Une équipe américaine vient de le réussir en s'aidant de gouttes d'eau. Pour l'instant, la trouvaille ne sort pas du labo mais elle est prometteuse.

Pour obtenir le rendement maximum d'une cellule photovoltaïque, il faut l'orienter perpendiculairement aux rayons lumineux. Mais le Soleil bouge (les astronomes prétendent depuis quelques siècles que c'est en fait la Terre qui tourne) et les panneaux solaires ne sont pas toujours posés sur une structure fixe. Certains en installent sur des sacs à dos, des voiliers, des voitures, des planeurs, des ULM et l'équipe du projet Solar Impulse veut même en faire la seule source d'énergie d'un avion tandis que d'autres veulent rendre ces cellules solaires imprimables

Sur le plan théorique, un capteur courbe devrait atteindre un meilleur rendement. C'est aussi une manière d'augmenter la surface. Si on réalise une demi-sphère par exemple, au lieu d'un plan, on double la surface. Mais les cellules photovoltaïques sont de petites tailles et constituées de matériaux semi-conducteurs qui se prêtent bien la réalisation de surfaces planes. Obtenir des structures courbées n'est pas aisé surtout si l'on se donne des contraintes de coûts.

Menée par Ralph Nuzzo, une équipe de l'Université de l'Illinois à Urbana-Champaign propose une méthode de fabrication originale et élégante par auto-assemblage, publiée dans les Pnas. Ces chercheurs se servent de minuscules films de silicium qui se plient tout seuls autour de gouttes d'eau pour donner différentes formes.

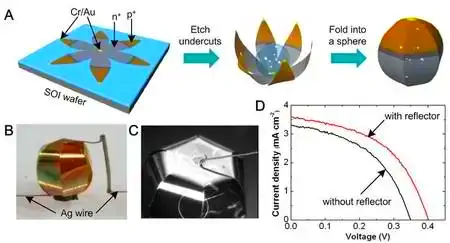

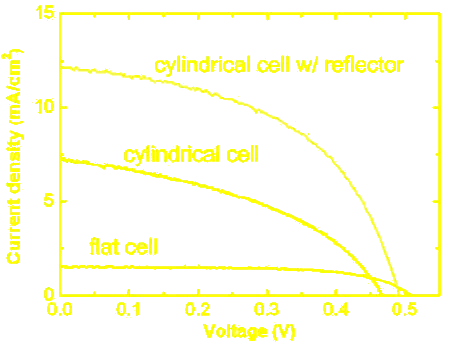

Les étapes de l'auto-assemblage d'une cellule solaire 3D (cliquer sur l'image pour l'agrandir). Le circuit (un semi-conducteur avec une partie dopée positivement, p+ et une partie dopée négativement, n+) est gravé sur une galette de silicium (SOI wafer), par les techniques classiques de lithogravure, avec ses contacts électriques (Cr/Au, chrome et or). Très fin (ici 2 microns), le composant obtenu est dégagé par une attaque chimique (Etch undercuts), un procédé classique lui aussi et on dépose une goutte d'eau. L'origami se referme alors comme prévu, en une sphère. En bas, le résultat. Des électrodes sont soudées et les courbes montrent l'intensité obtenue (milliampères/cm²) en fonction de la tension (voltage). Le résultat est amélioré par la présence d'un réflecteur, sorte de cuvette réfléchissante dans laquelle on dépose cette sphère.

L'équipe est partie d'une galette de silicium et a utilisé les techniques classiques de lithogravure pour graver les composants d'une cellule photovoltaïque. Reste alors à plier cet origami minuscule, de quelques millimètres de côté pour une épaisseur de 1, 25 à 2 microns. L'idée est d'utiliser les forces de tension superficielle apparaissant entre ce film et une goutte d'eau, la mince feuille ayant tendance à s'enrouler autour.Pour obtenir une certaine forme tridimensionnelle, les chercheurs ont, au moment même de la gravure, dessiné le composant selon une géométrie complexe, à la manière d'un cartonnage prédécoupé qui permettra d'obtenir un objet, une boîte par exemple.

Une fois le composant réalisé sur la galette, une goutte d'eau est posée au centre... et le miracle s'accomplit. A mesure que l'eau s'évapore, le film de silicium, comme une fleur qui se refermerait, se replie pour adopter une certaine forme.

En fait de miracle, une grande partie de l'astuce consiste à déterminer précisément quel découpage réaliser sur la galette pour obtenir la forme voulue. Le terme d'origami n'est pas usurpé et l'équipe a su mettre au point un modèle mathématique pour prédire cet auto-pliage en tenant compte de l'épaisseur du film, des caractéristiques du silicium et des forces induites par la tension superficielle pendant l'évaporation de l'eau.

Cet outil leur permet désormais, comme en témoignent les photographies publiées dans l'article, d'obtenir une gamme de formes variées. Pour stabiliser leurs minuscules structures, les chercheurs déposent un morceau de verre en leurs centres, fixé par un adésif.

Cellule photovoltaïque organique

Les cellules photovoltaïques organiques sont des cellules photovoltaïques dont au moins la couche active est constituée de molécules organiques.

Elles constituent une tentative de réduction du coût de l'électricité photovoltaïque, sans conteste la principale barrière de cette technologie, mais on espère aussi qu'elles seront plus fines, flexibles, facile et moins chères à produire, tout étant résistante.Les cellules photovoltaïques organiques bénéficient en effet du faible coût des semi-conducteurs organiques ainsi que de nombreuses simplifications potentielles dans le processus de fabrication.

Typologie

- Détail

- Il en existe principalement de trois type :

- Les cellules photovoltaïques organiques moléculaires

- Les cellules photovoltaïques organiques en polymères

- Les cellules photovoltaïques hybrides

On distingue dans les semi conducteurs organiques les polymères, qui se déposent par centrifugation, des matériaux de petites molécules déposés eux par thermo-évaporation.

Utilisant comme substrat du plastique (PEN, PMMA ...), ces cellules offrent la perspective d'une production en continu (roll-to-roll) qui permettrait enfin l'accès à des panneaux solaires à un prix raisonnable.

Encore au stade de la recherche expérimentale, le record de rendement avec des cellules solaires en polymère était en 2008 compris entre 4 et 5%. En 2008, en laboratoire, un record mondial de 5, 9% a été atteint en juillet 2008 à l'Institut de photovoltaïque appliquée de l'Université technique de Dresde.

Les cellules photovoltaïques à base de molécules organiques offrent un rendement moins élevé encore que les cellules en polymère, mais leur performance a été améliorée récemment. En 2009, des chercheurs des universités françaises d'Angers et de Strasbourg ont réussi à augmenter leur rendement en le faisant passer de 0, 2% à 1, 7%. En 2010, une équipe de chercheurs américaine a de nouveau amélioré ce rendement en le portant à 2, 5%.

Les cellules polymères photovoltaïques désignent une technique de cellules solaires organiques produisant de l'électricité à partir de la lumière à l'aide de polymères semiconducteurs. Il s'agit d'une technique relativement récente étudiée en laboratoire par des groupes industriels et des universités à travers le monde.

Encore largement au stade expérimental, les cellules polymères photovoltaïques offrent néanmoins d'intéressantes perspectives. Elles reposent sur des macromolécules organiques dérivées de la pétrochimie, dont les procédés de fabrication sont bien moins consommateurs d'énergie que ceux mis en oeuvre pour les cellules à base de semiconducteurs minéraux. Leur coût de revient est bien plus faible et elles sont plus légères et moins fragiles. Leur nature flexible les rend même aptes à s'intégrer à des matériaux souples en polymères organiques ou en silicones, voire à des fibres textiles. Leur développement peut tirer parti des progrès du génie chimique, par exemple dans l'auto-assemblage de ces molécules. Leur principale faiblesse réside dans leur durée de vie encore limitée induite par la dégradation des polymères lorsqu'ils sont exposés au soleil.

Principe de fonctionnement

La physique sous-jacente à l'effet photovoltaïque dans les semiconducteurs organiques est plus complexe à décrire que celle des cellules à semiconducteurs minéraux. Elle fait intervenir les différentes orbitales moléculaires, certaines jouant le rôle de bande de valence, d'autres de bande de conduction, entre deux espèces moléculaires distinctes, l'une servant de donneur d'électrons et l'autre d'accepteur, organisées autour d'une hétérojonction comme dans le cas des semiconducteurs minéraux :

- Détail

- Les molécules servant de donneurs d'électrons (par génération d'excitons, c'est-à-dire de paires électron-trou) sont caractérisées par la présence d'électrons p, généralement dans un polymère conjugué dit de type p

- Ces électrons peuvent être excités par des photons visibles ou proches du spectre visible, les faisant passer de l'orbitale moléculaire haute occupée (jouant ici un rôle similaire à celui de la bande de valence dans un semiconducteur inorganique) à l'orbitale moléculaire basse vacante (jouant un rôle similaire à celui de la bande de conduction) : c'est ce qu'on appelle la transition p-p* (qui correspond, en poursuivant l'analogie avec les semiconducteurs minéraux, à l'injection des porteurs dans la bande de conduction à travers la bande interdite).L'énergie requise pour cette transition détermine la longueur d'onde maximale qui peut être convertie en énergie électrique par le polymère conjugué.

- Contrairement à ce qui se passe dans un semiconducteur inorganique, les paires électron-trou, dans un matériau organique, demeurent étroitement localisées, avec un couplage fort (et une énergie de liaison comprise entre 0, 1 et 1, 6 eV), la dissociation des excitons est réalisée à l'interface avec un matériau accepteur d'électrons sous l'effet d'un gradient de potentiel chimique à l'origine de la force électromotrice du dispositif. Ces accepteurs d'électrons sont dits de type n.

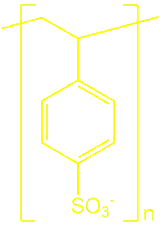

Structure de polymères conducteurs : polyacétylène, poly(para-phénylène-vinylène) (PPV), polyaniline (X = N, NH), sulfure de polyphénylène (X = S), polypyrrole (X = NH) et polythiophène (X = S).

Les cellules photovoltaïques organiques utilisent souvent des films en poly(éthylène naphtalate) (PEN) comme revêtements protecteurs en surface, dont le rôle essentiel est de prévenir l'oxydation des matériaux constituant les cellules photovoltaïques organiques : O2 est en effet une impureté qui agit comme un centre de recombinaison électron-trou, dégradant les performances électroniques des composants. Sous ces revêtements protecteurs, on trouve une ou plusieurs jonctions p-n entre matériaux donneurs et accepteurs d'électrons, comme dans une cellule photovoltaïque classique à semiconducteurs minéraux.

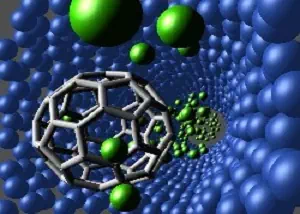

Un exemple de réalisation consiste à insérer des molécules de fullerène C60 comme accepteurs d'électrons (type n) entre des chaînes de polymères conjugués (telles que le PEDOT:PSS, formé de poly(3, 4-éthylènedioxythiophène)(PEDOT) comme donneur d'électrons (type p) mélangé au poly(styrène sulfonate) (PSS) assurant sa solubilité).

D'une manière générale, les recherches actuelles se portent par exemple sur des dérivés de polythiophènes comme polymères de type p, notamment le poly(3-hexylthiophène) (P3HT) avec des dérivés de fullerène comme accepteurs (type n) tels que le [6, 6]-phényl-C61-butyrate de méthyle (PCBM).

D'autres couples p / n sont investigués, notamment à base de para-phénylène-vinylène (PPV) comme donneurs, tels que MEH-PPV / PCBM ou MDMO-PPV / PCBM, ou à la fois comme donneurs et comme accepteurs, tels que MDMO-PPV / PCNEPV

Cellule multi-jonction

Des cellules ayant une grande efficacité ont été développées pour des applications spatiales. Les cellules multi-jonctions sont constituées de plusieurs couches minces qui utilisent l'épitaxie par jet moléculaire.

Une cellule triple jonction, par exemple, est constituée des semi-conducteurs GaAs, Ge et GaInP2. Chaque type de semi-conducteur est caractérisé par une longueur d'onde maximale au-delà de laquelle il est incapable de convertir le photon en énergie électrique. D'un autre côté, en deçà de cette longueur d'onde, le surplus d'énergie véhiculé par le photon est perdu. D'où l'interêt de choisir des matériaux avec des longueurs aussi proches les unes des autres que possible (en multipliant leur nombre d'autant) de manière à ce qu'une majorité du spectre solaire soit absorbé, ce qui génère un maximum d'électricité à partir du flux solaire. Le coût de ces cellules est de l'ordre de USD 40 $ / cm².

Semi conducteur cis

La technique consiste à déposer un matériau semi-conducteur à base de cuivre, de gallium, d'indium et sélénium sur un support.

Une inquiétude cependant : les ressources en matières premières. Ces nouvelles techniques utilisent des métaux rares comme l'indium dont la production mondiale est de 25 tonnes par an et le prix d'avril 2007 de 1000 dollars le kg, le tellure dont la production mondiale est de 250 tonnes par an, le gallium d'une production de 55 tonnes par an, le germanium d'une production de 90 tonnes l'an. Bien que les quantités de ces matières premières nécessaires à la fabrication des cellules solaires soient infinitésimales, un développement massif mondial des panneaux solaires photovoltaïques en couches minces sans silicium ne manquerait pas de se heurter à cette disponibilité physique limitée.

cellule photovoltaïque nouvelle génération

Une nouvelle technologie de cellules photovoltaïques permettrait d'augmenter considérablement le rendement de l'énergie solaire. Un projet national de recherche sur les cellules photovoltaïques devrait donner lieu à la production d'une troisième génération de cellules photovoltaïques.

Ces cellules se basent sur une nouvelle technologie, mise en place notamment par des chercheurs de NTNU (université de Trondheim), de l'université d'Oslo, de SINTEF et de l'IFE (institut de technologies pour l'énergie).

C'est le résultat d'une collaboration plus vaste entre ces instituts de recherches et universités et des partenaires privés (Elkem Solar, Fesil Sunergy, Hydro, Norsun, Prediktor, REC, Scatec, Solar Cell Repower, Umoe Solar) regroupés au sein du Centre norvégien pour la recherche sur la technologie de cellule photovoltaïque (un des centres de recherche pour des énergies durables mis en place par le Conseil Norvégien pour la Recherche).

Les cellules photovoltaïques actuelles ont un rendement de 16 à 18%. Au maximum elles pourraient atteindre un rendement de 29% (limite dite de Shockley-Queisser). Les nouvelles cellules que les chercheurs norvégiens développent pourraient atteindre un rendement de 60 à 80%. Cela passe à la fois par l'utilisation optimale des propriétés énergétiques de la lumière du soleil (en utilisant tout le spectre de cette lumière et non pas une seule partie de celui-ci) et par l'amélioration de certaines propriétés des cellules photovoltaïque actuelles.

La technologie actuelle

Lorsque la lumière du soleil arrive sur un solide, de la silice pour les cellules photovoltaïques, l'énergie portée par les photons, particules de la lumière est transmise aux électrons de ce solide. Les électrons augmentent ainsi leur propre énergie.

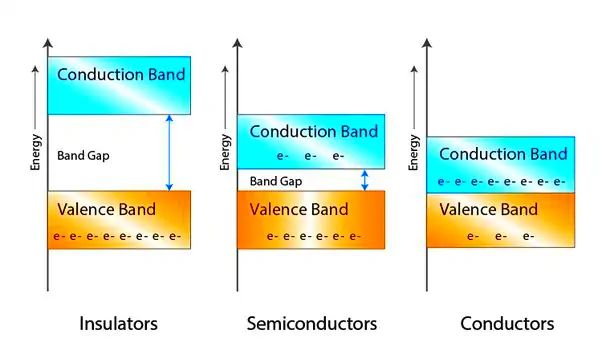

La théorie des bandes veut que dans un solide, les différents électrons présents dans les atomes aient des états d'énergie différents les uns des autres. Cependant, ces états d'énergie ne sont pas aléatoires : ils sont compris à l'intérieur de bandes de niveaux d'énergie (voir illustration) et ne peuvent pas avoir des niveaux d'énergie en dehors de ces intervalles.

Deux bandes sont particulièrement importantes: la bande de valence et la bande de conduction. La bande de valence correspond à la dernière bande complètement remplie en électrons (on ne peut pas rajouter d'autres électrons dans cette bande), la bande de conduction est celle qui suit (incomplète en électrons).

Pour passer de l'une à l'autre, un électron a besoin de recevoir une quantité d'énergie supérieure à l'intervalle entre les deux bandes. Dans le cas présent, cette énergie est apportée par les photons de la lumière. Cette différence d'énergie entre les deux bandes est appelée "band gap". Une fois qu'il a dépassé ce "band gap", l'électron de la bande de conduction est libre de circuler dans le solide (il n'est plus lié à son atome) : c'est l'effet photovoltaïque (ou photoélectrique).

La lumière solaire est composée de plusieurs longueurs d'ondes : cela signifie que les photons ne portent pas tous la même quantité d'énergie. Certains en auront suffisamment pour faire passer le "band gap" à un électron, d'autres non. C'est une des raisons qui limite le rendement des cellules photovoltaïques classiques : beaucoup de photons qui arrivent ne servent à rien.

Pour obtenir un maximum d'électricité au final, il faut qu'un maximum d'électrons puisse passer de la bande de valence à la bande de conduction. D'autre part, certains photons apportent une énergie supérieure à celle nécessaire pour passer la band gap, le reste est donc de l'énergie perdue (sous forme de chaleur).

Ce que les chercheurs norvégiens ont fait de nouveau : changer la structure de la cellule photovoltaïque pour rajouter des structures en nanocristaux à la structure en Silice, permettant ainsi de :

- Détail

- Convertir les photons trop énergiques en deux photons moins énergiques (mais d'énergie toujours suffisante pour passer la band gap): c'est la down-conversion. Cela permet de faire passer plus d'un électron sur la bande de conduction avec un seul photon incident.

- Combiner deux photons d'énergie trop faible pour en créer un de niveau suffisant pour dépasser la Gap Band : c'est l'up-conversion.

En produisant également des cellules qui peuvent avoir différents band gap, on peut penser que cela permettrait de convertir l'ensemble du spectre solaire.

D'autre part, lorsque l'électron passe de la bande de valence à la bande de conduction, il laisse un "trou" dans la bande de valence (elle n'est pas complètement remplie en électrons). Dans le cas de l'effet photovoltaïque naturel, l'électron, arrivé sur la bande de conductance, trouve rapidement un autre "trou" et revient sur la bande de valence. L'énergie apportée initialement par le photon est alors perdue. Dans les cellules photovoltaïques, la structure force les électrons libres à aller à l'opposé des "trous", afin de créer une différence de potentiel, entre le pôle + (le trou) et le pôle -(l'électron), comme dans une pile.

Plus on maintient longtemps cette différence de potentiel plus on récupère d'électricité. Il faut donc que l'électron de la bande de conduction reste longtemps sans retrouver un "trou". Avec la technologie actuelle, ce temps est de l'ordre de la nano- ou de la microseconde. Les matériaux que les norvégiens sont en train élaborer permettraient de prolonger cette durée jusqu'à un millième de seconde.

Centrale solaire thermodynamique

Une centrale solaire thermique (ou centrale solaire thermodynamique ou encore heliothermodynamique) est une centrale qui concentre les rayons du soleil à l'aide de miroirs afin de chauffer un fluide caloporteur qui permet en général de produire de l'électricité.

Types et filières

- Détail

- On distingue :

- centrale à tour

- centrale constituée de capteurs cylindro paraboliques

- centrale constituée de capteurs paraboliques

- centrale constituée de capteurs de fresnel

Une centrale à tour est constituée d'un champ de capteurs solaires spéciaux appelés héliostats qui concentrent les rayons du soleil. Les miroirs sont concentrés sur des tubes où un liquide caloporteur est porté à haute température. Ce liquide caloporteur envoyé dans une chaudière transforme de l'eau en vapeur. La vapeur fait tourner des turbines qui entrainent des alternateurs produisant de l'électricité.

Tour solaire

Dans ce concept, les rayons solaires ne sont pas concentrés. L'air est chauffé par une grande surface de collecteurs (une sorte de gigantesque serre) avant de s'échapper par une grande cheminée centrale, en passant par des turbines situées à son pied. Dans le projet de Buronga (Australie), la cheminée atteindrait 1000 m de hauteur et la surface de collecteur, 7 km de diamètre.

Ce type de centrale se compose d'alignements parallèles de longs miroirs hémicylindriques, qui tournent autour d'un axe horizontal pour suivre la course du soleil.

Les rayons solaires sont concentrés sur un tube horizontal, où circule un fluide caloporteur qui servira à transporter la chaleur vers la centrale elle-même.

La température du fluide peut monter jusqu'à 500° C. Cette énergie est transfèrée à un circuit d'eau, la vapeur alors produite actionne une turbine qui produit de l'électricité.

Certaines centrales sont désormais capable de produire de l'électricité en continu, nuit et jour, grace à un système de stockage de la chaleur.

Le miroir parabolique réfléchit les rayons du soleil vers un point de convergence, le rayonnement solaire est alors concentré sur le récepteur qui monte en température.